Zapraszamy na premierę najnowszego odcinka podcastu NIELINIOWY na Youtube w którym Michal Dulemba rozmawia z ekipą techniczną naszego projektu: Maria Filipkowska, PhD, Jacek Chwiła, Adrian Gwoździej, Grzegorz Urbanowicz i Paweł Kiszczak.

https://lnkd.in/dESakTbb

Rozmowa m.in. na temat:

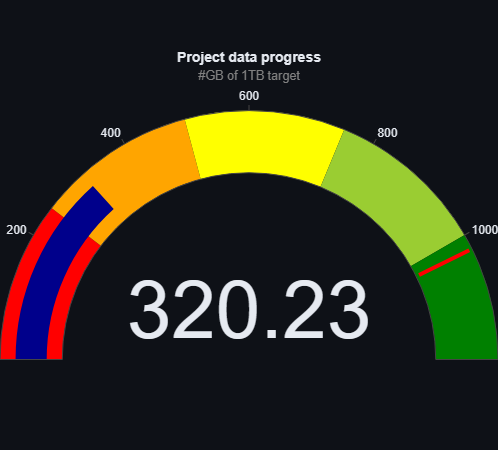

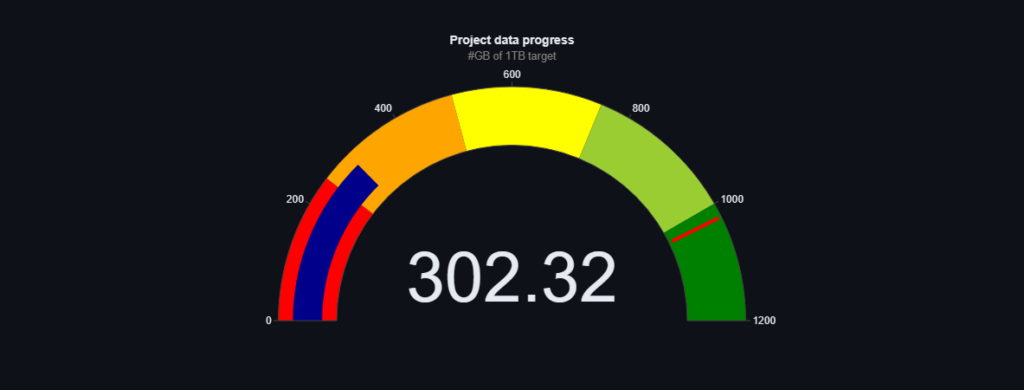

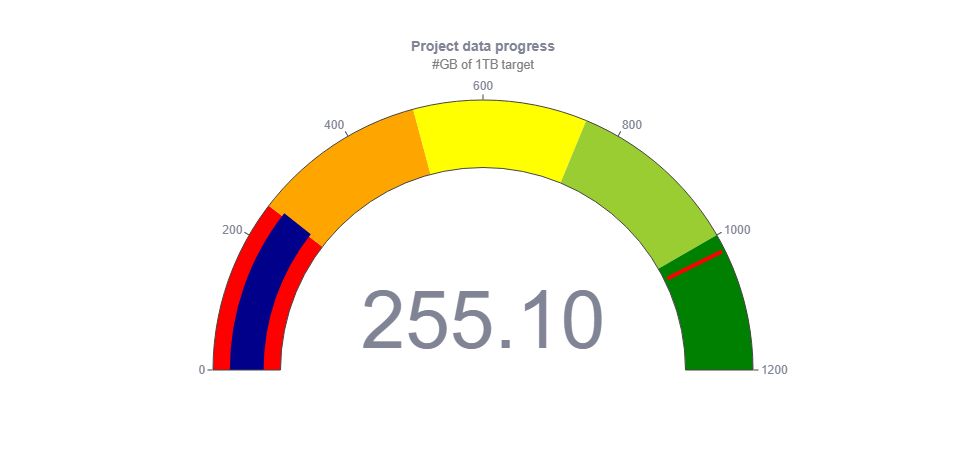

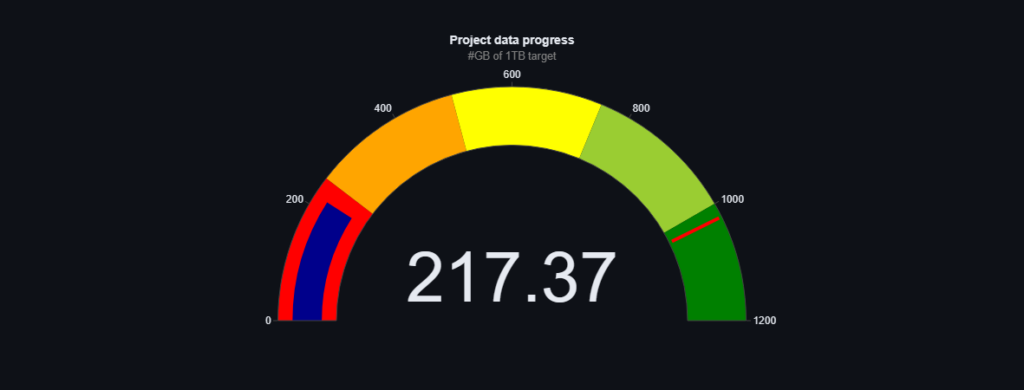

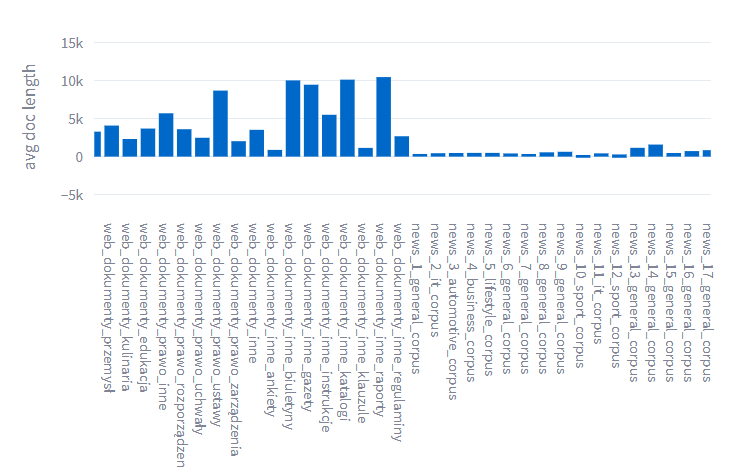

– ile danych już udało się zebrać

– różnorodności danych tekstowych

– sztucznie generowanych danych tekstowych

– kilometrach danych w archiwach państwowych

– motywacji członków ekipy

– korzyści z przystąpienia do Spichlerza

– różnorodności umiejętności technicznych przydatnych w Spichlerzu

– wpływu Spichlerza na rekrutację

– dumy z pracy nad typowo polskim projektem