🚀 Chcemy razem z Wami stworzyć największy projekt citizen science dla AI w Europie! 🇪🇺 m.in. z SpeakLeash | Spichlerz (ale nie tylko)!

Bo przełomy w AI to nie tylko nowe architektury i tona GPU. To też nowe podejście do zarządzania danymi, trenowania modeli i tworzenia jakościowych zbiorów. Innowacja to także ludzie – ich wiedza, pasja i zaangażowanie.

📸 Zamiast generować kolejne selfi w stylu bohaterów filmów Studia Ghibli 🐱🚀… zrobisz zdjęcie swojej okolicy, lokalnej potrawy 🍲, zabytku, zwyczaju — i dobrze je opiszesz. To właśnie takich danych potrzebuje polska AI, by rozumieć nasz świat.

Pokażmy Polsce i światu, jak wygląda nasza kultura widziana naszymi oczami! Ale od początku: zerknijcie na naszą prezentację (poniżej) i zobaczcie, jak obecne modele image-text-to-text radzą sobie z opisem polskich potraw.

Spoiler: słabo 😅 A przecież te modele mogą wspierać polski e-commerce, pomagać osobom z niepełnosprawnościami 👁️🗨️ i zwiększać dostępność cyfrową.

🧠 Mamy już modele tekstowe – BIELIK.AI i PLLuM. Dwa duże LLM-y zbudowane w Polsce! Teraz czas na wizję – dosłownie. Model, który rozumie obrazy. I tu wchodzi cały na biało… hashtag#ObywatelBielik 🤍🦅

Będzie to aplikacja webowa i mobilna, w której każdy będzie mógł wrzucać i opisywać zdjęcia. Nie potrzebujemy dzieł sztuki ani selfie – szukamy zdjęć lokalnych potraw, przyrody, tradycji, zabytków.

👉 Chcemy stworzyć:

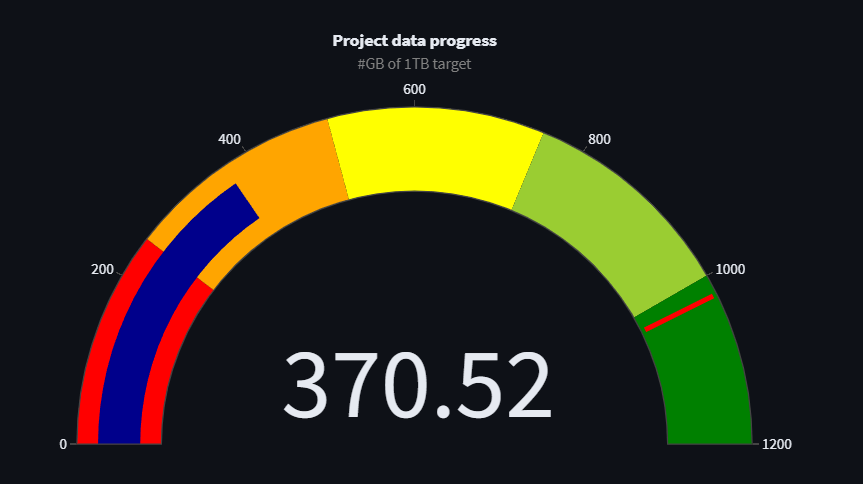

1️⃣ Największy otwarty zbiór danych obrazów

2️⃣ W całości zbudowany przez obywateli – wspierany przez szkoły, instytucje kultury, lokalne społeczności 🇵🇱

3️⃣ 1 milion zdjęć i opisów w jeden kwartał! 📸

I nie będziemy sami – dołączają do nas duże instytucje 💪 (o szczegółach już niedługo – trwają podpisy 👀).

Obywatel Bielik